Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

有趣分享

有趣分享

Qwen-Image-Edit 是一款专注于图像精修与文字编辑的 AI 模型,能够在不破坏原始设计结构的前提下,对图片中的文字进行精准替换,完整保留字体风格、排版结构与背景光影。本文将深入解析它为何能解决“AI 改字容易翻车”的长期难题,以及这一能力对设计与商业场景的实际价值。

在当前图像生成模型百花齐放的时代,“生成一张好看的图”已经不再是最难的事。

真正困难的,是在不破坏原有结构的前提下,只改你想改的那一点点。

而在所有图像编辑任务中,有一件事长期被低估,却异常困难——

在图片中精准地改字,而且改得毫无破绽。

Qwen-Image-Edit,恰恰在这件事上,做对了。

乍一看,把图片里的文字换掉,似乎是一件再普通不过的需求。

但只要你真正用过各类 AI 修图模型,就会发现,这恰恰是它们最容易翻车的地方。

常见翻车现场包括:

尤其是在中文、书法、中英文混排、复杂设计图这些场景下,失败率会直线上升。

这并不是模型不够聪明,而是这件事本身,对 AI 来说难度极高。

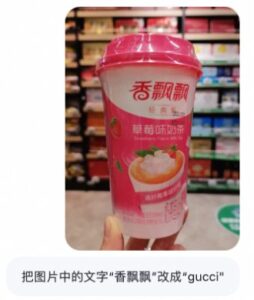

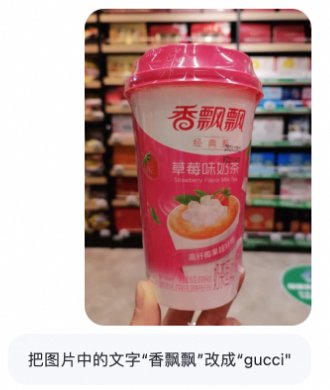

你在文章里举的这个例子,其实非常精准。

把一张“香飘飘”的图,改成“GUCCI”。

这并不是一次重新生成,而是一次从 0.97 到 1.00 的精修。

这意味着模型需要同时满足:

对人类设计师来说,这已经是高级修图技巧;

对 AI 来说,这是多个高难度能力的叠加。

而大多数图像模型,本质上是为“生成”而生,不是为“精修”而设计的。

问题并不在单一环节,而在系统能力缺失。

很多模型在改字时,会出现以下根本性问题:

模型并没有真正理解文字的语义结构,只是把它当成普通纹理处理。

结果就是:

一旦修改区域稍大,整个版式就被连带破坏。

要么改得太少,要么改得过头。

这是很多海外模型的通病,尤其在汉字和书法场景中暴露无遗。

Qwen-Image-Edit 并不是“运气好”,而是在架构设计上走了一条更难、但更正确的路。

它的核心在于一套双路径协同机制。

这一部分负责:

它不是简单地“生成新图”,而是明确知道:

👉 哪些地方不能动,哪些地方必须动。

这一部分负责:

最终效果是:

改过,但看不出改过。

如果用人类来类比,Qwen-Image-Edit 就像这样一个组合:

三者同时在线,才可能完成一次**“低入侵、高精度”的编辑**。

这也是为什么它在改字这件事上,显得格外“克制”。

从应用角度来看,现实世界里真正高频的需求并不是“从零生成”。

而是:

这些场景,99% 都要求结构保持不变。

所以,未来图像 AI 的价值,并不只在“更好看”,而在于:

能不能在不破坏原有设计的前提下,完成一次精确修改。

我们经常讨论一个宏大的问题:

中国能不能做出对标 GPT 的模型?

这个问题太大,也太抽象。

但如果换一个角度:

能不能在某些被忽视的细分能力上,先做到世界领先?

Qwen-Image-Edit 在“文字编辑、结构保持、复杂字体还原”这件事上,给出了一个非常明确的答案。

即便放在全球范围内,这个能力也是稀缺的。

即便是 GPT、Gemini、Claude 这类顶级模型:

你提到的 nano-banana,汉字表现更是灾难级别。

相比之下,Qwen-Image-Edit 在:

这些点上,反而显得异常稳健。

在人类设计师圈子里,有一句经典标准:

最好的修图,是看不出来修过。

而 Qwen-Image-Edit,在某些场景下,已经无限接近这个目标。

尤其是在书法、老图、品牌设计这些**“不能动结构”的场景中**,它的优势非常明显。

也许,图像 AI 的未来,并不只是一味追求更炫、更炸裂的生成效果。

而是学会:

在这一点上,Qwen-Image-Edit,确实走在了前面。

要发表评论,您必须先登录。

hmjrcp

cqvfci