Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

有趣分享

有趣分享

一个长期维护、持续更新的中文敏感词库项目,覆盖政治、色情、暴力等高风险领域,适合开发者、内容平台与自媒体进行文本过滤与内容审核,是中文内容安全中不可或缺的基础资源。

在中文互联网环境中,「内容审核」始终是一个绕不开的话题。

无论你是做 网站、App、小程序、论坛、评论系统,还是在运营 自媒体、社区、UGC 平台,都会遇到一个现实问题:

如何快速、稳定、低成本地识别敏感内容?

这时候,一个 可靠、持续更新、覆盖全面的中文敏感词库,就显得尤为重要。

今天要分享的这个项目 —— Sensitive-lexicon,正是一个长期维护、社区驱动、被大量开发者使用的 中文敏感词库开源项目。

👉 项目地址:

https://github.com/konsheng/Sensitive-lexicon

Sensitive-lexicon 是一个专注于 中文敏感词整理与维护 的开源词库项目。

它并不是某个平台的内部规则,也不是商业 API,而是一个:

的基础词汇资源。

项目中收录了 数万条中文敏感词,涵盖多个高风险领域,包括但不限于:

对开发者来说,它更像是一个 内容安全的“底层素材库”。

在绝大多数内容审核系统中,敏感词检测永远是第一步。

哪怕你后面接了:

前置过滤 仍然离不开一个词库。

Sensitive-lexicon 的最大价值就在于:

👉 用最低成本,快速筛掉最明显的违规内容

现实情况是:

根本没有精力和预算从零维护一套完整敏感词体系。

而 Sensitive-lexicon 的优势在于:

非常适合早期项目快速落地。

你会发现一个很有意思的现象:

翻一翻词库本身,其实也是一次对“灰色世界”的认知升级。

很多词汇:

对 内容创作者、平台运营、SEO 从业者 来说,本身就具备很强的学习价值。

项目收录的词汇规模达到 数万条,且分类清晰,覆盖当前主流敏感领域。

相比零散收集:

很多敏感词库最大的问题是:

更新停滞,几年不动

而 Sensitive-lexicon 的维护逻辑是:

这在中文互联网环境里 非常关键。

所有词库基本都是 TXT / 文本列表:

你可以在:

中 直接加载使用。

项目鼓励:

这意味着它不是“作者一个人的项目”,而是一个 持续演进的公共资源。

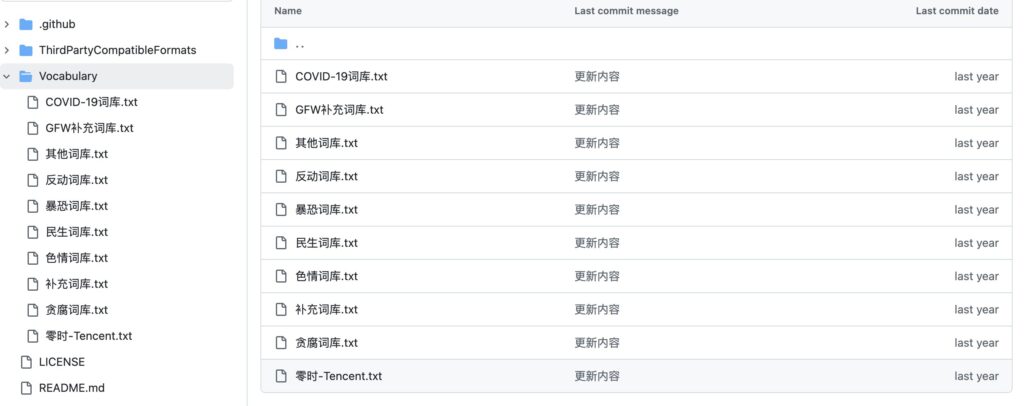

项目目录结构清晰,对开发者非常友好:

Sensitive-lexicon/

├── ThirdPartyCompatibleFormats/ # 第三方兼容格式

├── Organized/ # 已整理分类词库

├── Vocabulary/ # 原始词汇库

├── LICENSE

└── README.md

OrganizedVocabulary 二次处理ThirdPartyCompatibleFormats提前过滤高风险词汇,降低违规概率。

提前自检,避免限流、封号、审核失败。

在 AI 写作、AI 对话、AI 评论系统中:

敏感词库 = 最基础的安全防线

哪怕你已经接了大模型,也建议 本地先做一次词级过滤。

⚠️ 一个非常关键的提醒:

敏感词库 ≠ 内容审核的全部

正确的使用方式应该是:

Sensitive-lexicon 更适合扮演 “第一道门”,而不是最终裁决者。

总结一句话:

只要你和“中文内容”打交道,这个项目迟早会用上。

它不是花里胡哨的 AI 工具,而是:

的 基础设施级资源。